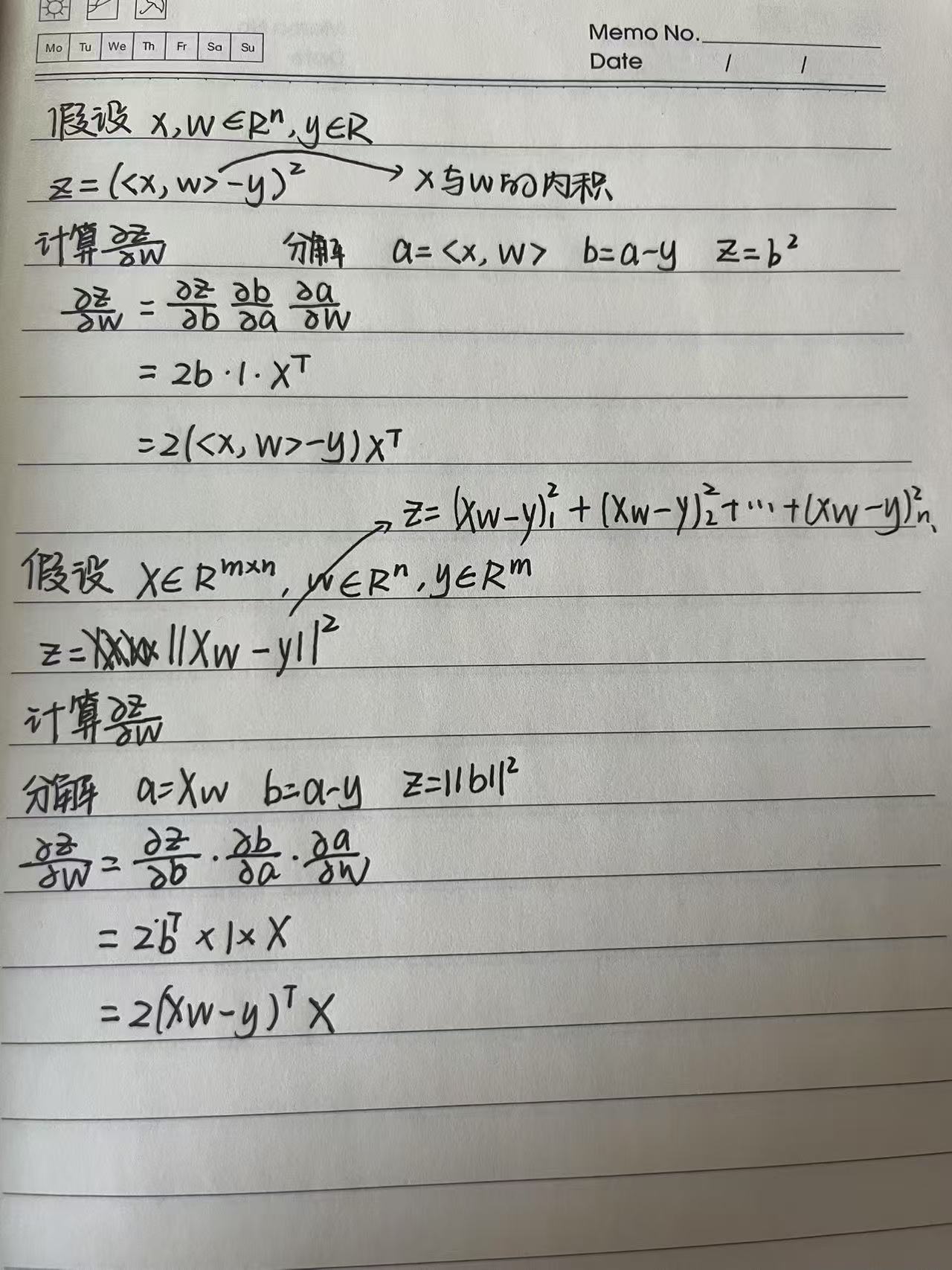

向量链式法则

- 标量链式法则

- 扩展到向量

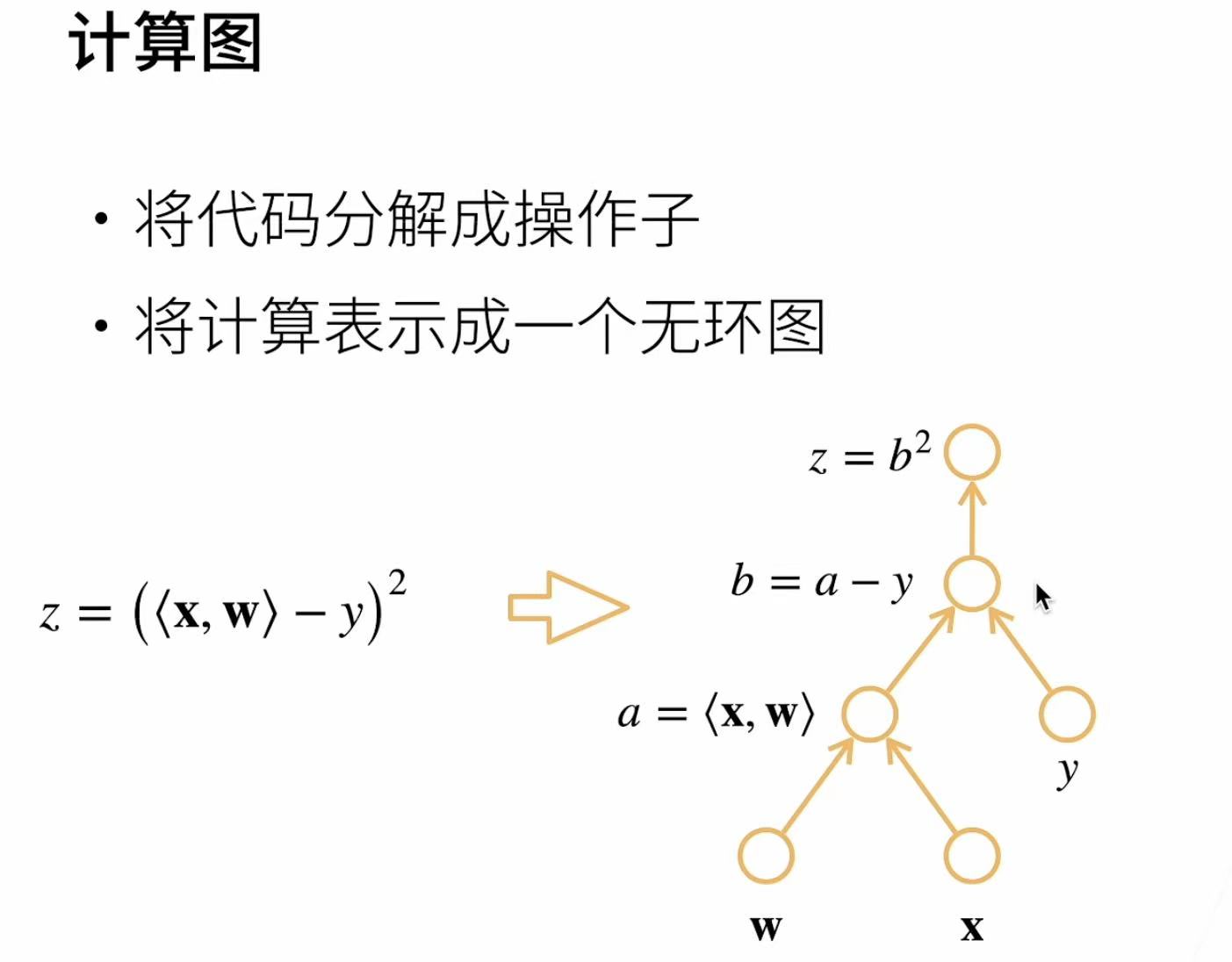

自动求导

- 自动求导就按一个函数在指定值上的导数

- 它有别于符号求导

也有别与数值求导

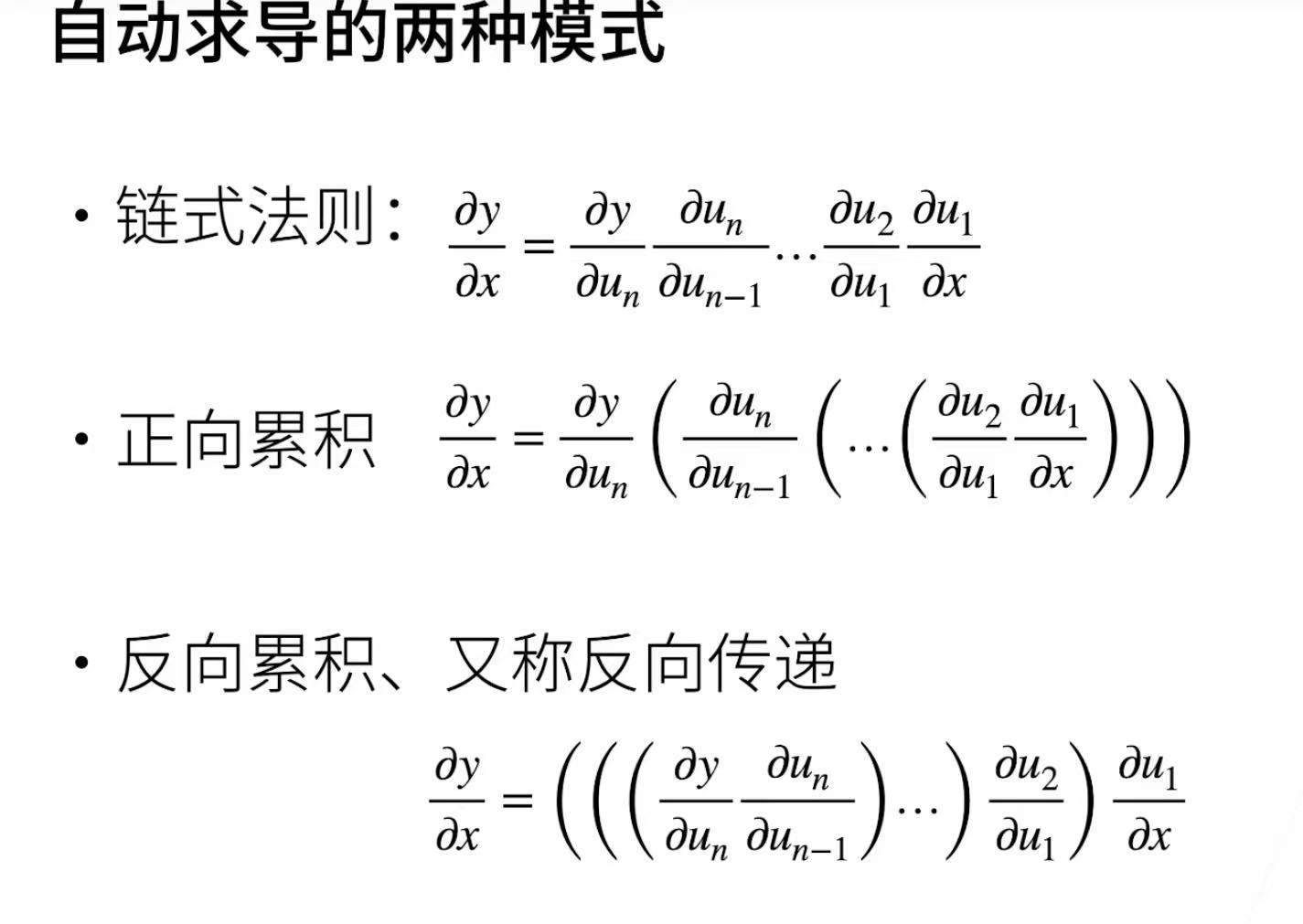

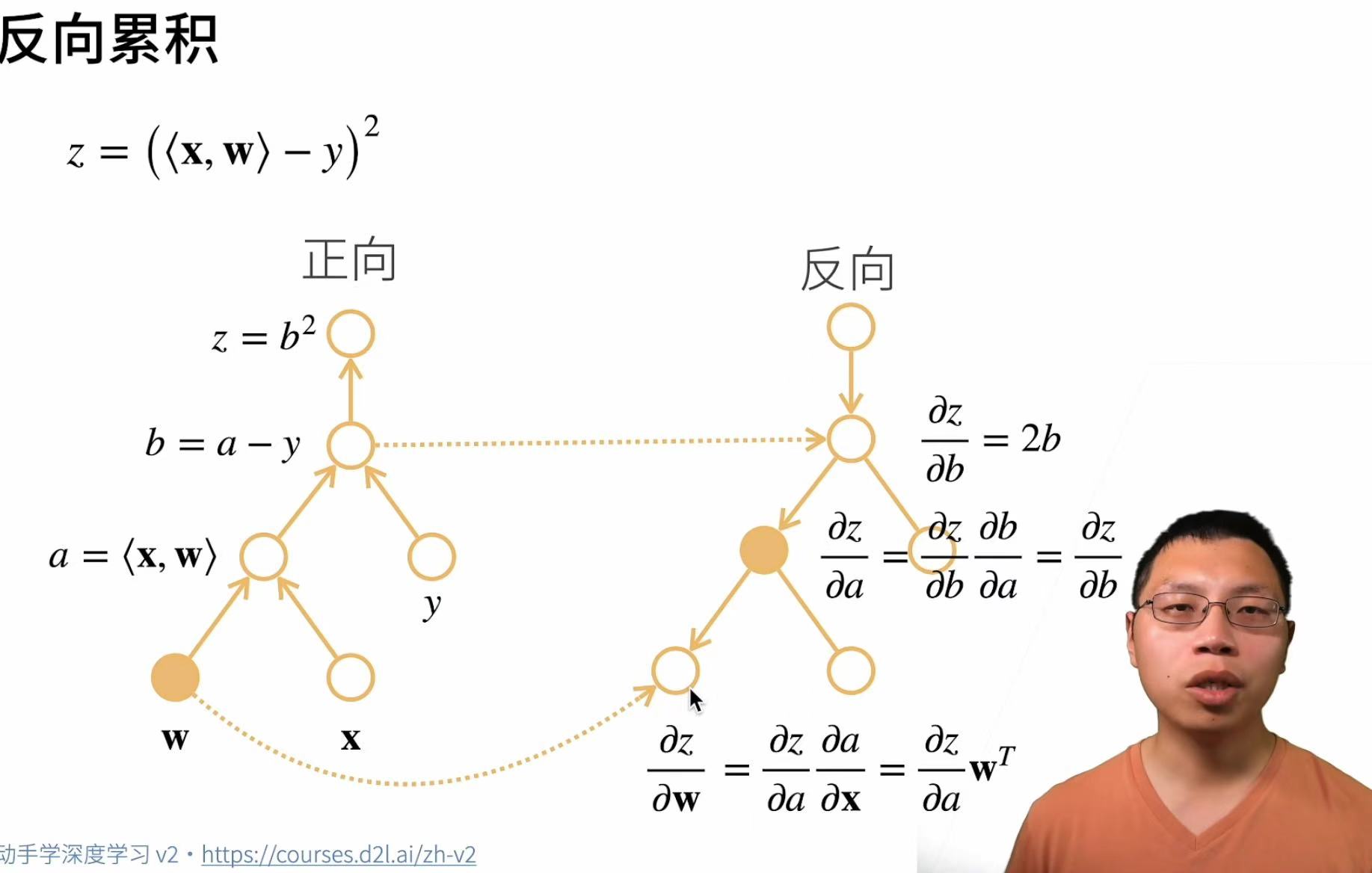

反向:从相反方向执行,去除不需要的枝

反向:从相反方向执行,去除不需要的枝

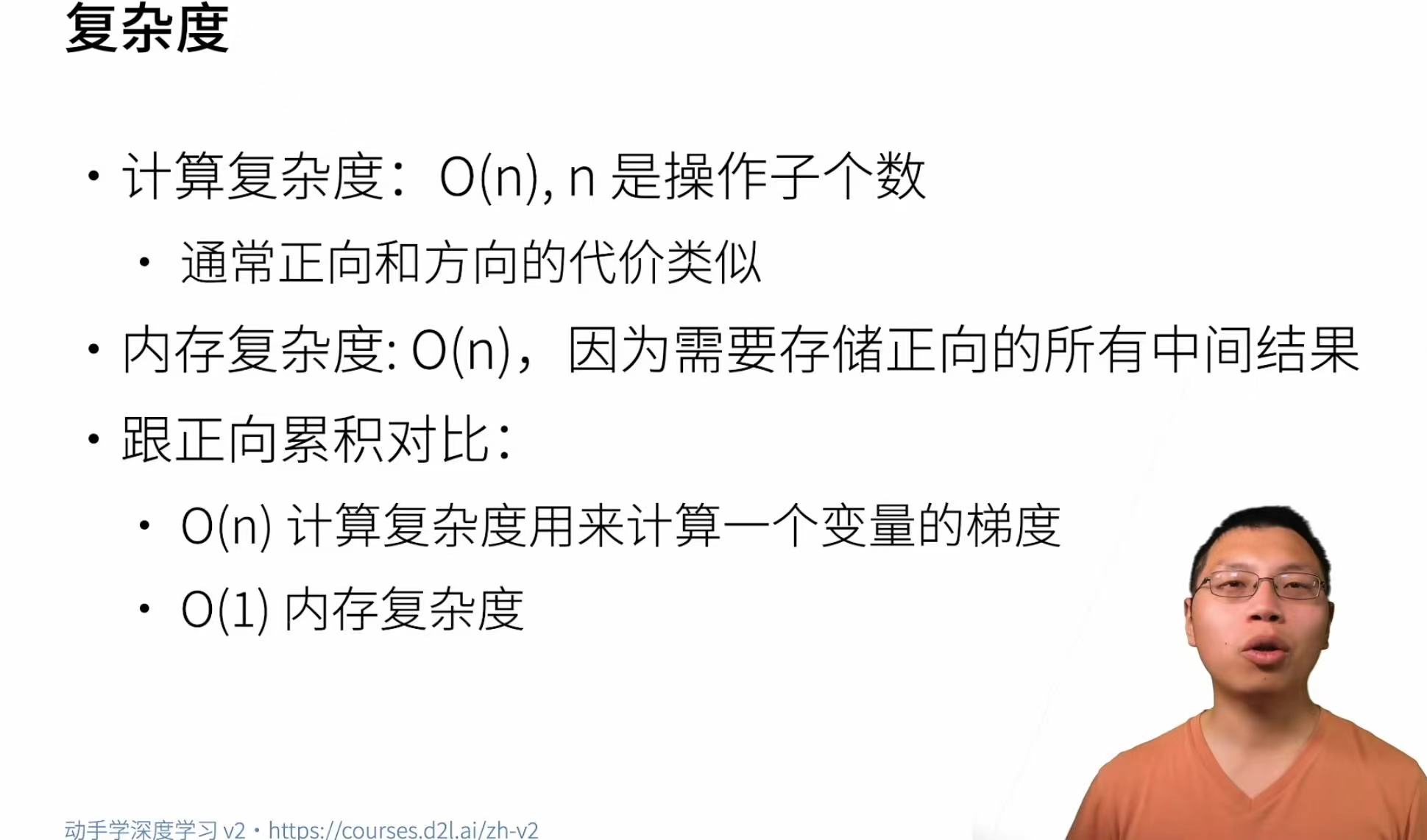

复杂度

正向求导不存数,只存一个数,去不断更新这个数,最后得导导数,而反向累积就是把数都存起来,到时候求什么就取需要的数来用。正向可以理解为求一个复合函数的值,正向会保留所有中间结果,反向就是求偏导数和梯度,会用到正向计算的中间结果。

x = torch.arange(4.0)为梯度计算做准备,启用的自动求导追踪 Pytorch中,只有设置requires_grad_(True)的张量,才会在计算后保存梯度信息(存储在.grad属性中)

x.requires_grad_(True)

x.gradtorch.dot(x,x)计算向量自身的点积,计算结果是一个标量

y = 2 * torch.dot(x, x)

ytensor(28., grad_fn=<MulBackward0>)通过调用反向传播函数自动计算y关于x每个分量的梯度,调用bcakward()后,梯度会存储在x.grad中,结果是4

y.backward()

x.grad

tensor([ 0., 4., 8., 12.])接着计算x的另一个函数,在默认情况下,Pytorch会累积梯度,我们需要清除之前的值

x.grad.zero_()

y = x.sum()

y.backward()

x.grad

tensor([1., 1., 1., 1.])x.grad.zero_()

y = x * x

y.backward(gradient=torch.ones(len(y)))

x.grad

tensor([0., 2., 4., 6.])对非标量求导调用backward()需要传入一个gradient参数 y.sum()将其转换为一个标量

x.grad.zero_()

y = x * x

y.sum().backward() #等价于y.backward(gradient=torch.ones(len(y)))

x.grad将某些计算移动到记录的计算图之外,u不再是关于x的函数,在z = u * x里u是被当成常数来对待(切断了u与原计算图的关联)

x.grad.zero_()

y = x * x

u = y.detach()

z = u * x

z.sum().backward()

x.grad == u

tensor([True, True, True, True])即使构建函数的计算图需要通过Python控制流(例如,条件、循环或者任意函数调用),我们仍然可以计算得到的变量的梯度

def f(a):

b = a * 2

while b.norm() < 1000:

b = b * 2

if b.sum() > 0:

c = b

else:

c = 100 * b

return c

a = torch.randn(size=(), requires_grad=True)

d = f(a)

d.backward()

a.grad == d / ab.norm()是b的范数,例如b = [1,2]时,范数是a = torch.randn(size=(), requires_grad=True)创建一个标量张量,size=()表示0维,即标量,并开启自动求导d = f(a)将a传入函数f